Abschlussarbeiten im Media Lab | 22.07.2025

Ethik per Klick: Ein Leitfaden für KI im Newsroom

Generative KI verändert Redaktionen – doch ohne klare Regeln wird der Fortschritt zur Gefahr für das eh schon umkämpfte Vertrauen der Rezipienten. Wie lassen sich also algorithmische Effizienz und journalistische Verantwortung versöhnen? Ein Versuch, KI ethisch in die Arbeitsprozesse von Medienschaffenden zu integrieren.

Redaktionen zwischen KI und Verantwortung

Der Siegeszug generativer Modelle hat Redaktionen in Rekordzeit elektrisiert, aber auch verunsichert. Interviews mit Medienschaffenden, Forschenden und Entwickelnden offenbaren eine ambivalente Haltung: Effizienzgewinne und Personalisierungspotenziale stehen Ängsten vor Qualitätsverlust, Bias und sinkendem Vertrauen des Publikums gegenüber. Ohne klare Leitplanken droht jede neue Anwendung zur Reputationsfalle zu werden.

Einige Kodizes geben bereits Prinzipien vor, bleiben im hektischen Redaktionsalltag jedoch abstrakt und aufgrund der Länge schwer zu handeln. Bisherige Forschung zeigte, dass einfache Bedienbarkeit ein must-have für KI im Journalismus ist. Daraus entstand meine Idee, einen interaktiven Leitfaden für Medienschaffende zu den wichtigsten Fragestellungen rund um den Einsatz von KI zu erstellen.

Meine Forschung: Von Interviews bis Prototyp

Der Weg dorthin war interativ und genau das war gut so. Schon in den ersten Interviews mit Medienschaffenden wurde deutlich: Die Haltung gegenüber KI ist gespalten. Viele sehen Potenzial, von automatisierter Recherche bis zur Zielgruppenanalyse. Gleichzeitig herrscht aber eine große Unsicherheit: Wann wird ein Text zu glatt? Wie kennzeichnet man KI-generierte Inhalte glaubwürdig? Und wer haftet eigentlich, wenn etwas schief geht?

Auch die Analyse bestehender Ethik-Leitfäden – unter anderem von UNESCO, EU-Kommission und Deutschem Journalisten-Verband (DJV) – zeigte schnell: Die Schlagworte darin sind „Transparenz“, „Menschenwürde“, „Verantwortung“, aber für den Arbeitsalltag fehlen oft konkrete Anleitungen, wie aus diesen großen Worten eine praktikable Entscheidung wird. Der berühmte Gap zwischen Theorie und Redaktionstisch.

Beim Prototyp-Test war das greifbar: Eine Redakteurin fragte etwa, ob es überhaupt erlaubt sei, ein KI-Tool für die Headline-Optimierung zu nutzen, wenn diese dann nicht mehr klar als maschinell erkennbar ist. Ein Entwickler wiederum monierte, dass ihm klare Richtlinien fehlen, wie er mit unfairen Trainingsdaten umgehen soll. Diese sehr unterschiedlichen Herausforderungen waren letztlich der Grund, warum ich den Leitfaden modular und rollenspezifisch aufgebaut habe – keine Ethik von der Stange, sondern passgenaue Impulse für verschiedene Rollen.

Inside Leitfaden: Modularität als Game Changer

Statt eines linearen PDFs präsentierte sich der Leitfaden den Testpersonen als Web-App:

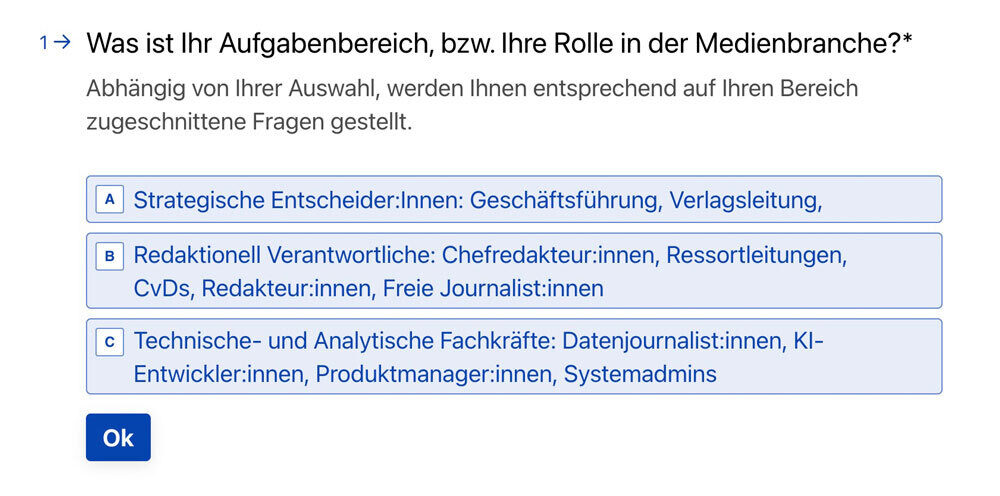

Rolle wählen: Ob strategische:r Entscheidungsträger:in, Redakteur:in oder technische Fachkraft – je nach Zuständigkeit stehen andere ethische Fragen im Vordergrund.

Die Rollenfrage steht direkt am Anfang des Leitfadens, um die relevanten Themenspektren einzugrenzen. (Screenshot von Typeform) - Themenmodule durcharbeiten: Nutzer:innen steigen abhängig von der Rollenauswahl in Themen wie zum Beispiel Kennzeichnung von KI-generierten Inhalten, Umgang mit Trainingsdaten, Datenschutz oder algorithmische Fairness ein.

- Handlungsempfehlungen erhalten: Am Ende jedes Moduls gibt es praxisnahe, auf das Themenmodul zugeschnittene Empfehlungen – zum Beispiel welche rechtlichen Vorgaben zu beachten sind, wie man Transparenz schafft oder wie man KI-Tools intern sinnvoll dokumentiert.

So landet die Redakteurin direkt bei Themen zum Quellencheck von KI-generierten Inhalten, während der Entwickler dazu befragt wird, wie weit er an einen Bias in Trainingsdaten gedacht hat.

Ausblick: Ethische Kompetenz als Wettbewerbsvorteil

Die Entwicklung des Leitfadens ist durch Abschluss meiner Masterarbeit beendet. Das Thema bleibt aber selbstverständlich in Bewegung – getrieben von gesellschaftlichen Dynamiken, die weit über einzelne Redaktionen hinausreichen:

Erstens verschiebt sich die öffentliche Erwartung an Medien rasant. Mit jedem neuen Deepfake und jedem automatisierten „Breaking News“-Tweet wächst der Ruf der Rezipienten nach Transparenz-Standards, die verifizierbar offenlegen, wann Algorithmen mitredigieren und welche Datenquellen sie nutzen. Teams, die gezielt Wissen über den sinnvollen und verantwortungsvollen Umgang mit KI aufbauen (AI-Literacy) und ethische Prinzipien von Anfang an in ihre Prozesse integrieren („Ethics by Design“), stärken sowohl ihre Glaubwürdigkeit als auch ihre Innovationskraft. Wer heute offenlegt, wie Algorithmen im Content-Flow wirken, sammelt morgen das Vertrauen der Rezipienten ein, das anderen Medienmarken abhanden kommen wird.

Parallel formiert sich auf regulativer Ebene ein deutlich schärferer Kurs. Die EU-KI-Verordnung und nationale Medienstaatsverträge skizzieren schon jetzt Prüf- und Offenlegungspflichten, die redaktionelle Prozesse verändern werden. Wer ethische Fragestellungen rund um KI ignoriert, riskiert absehbar nicht nur Shitstorms, sondern auch Bußgelder.

Schließlich wird auch das Publikum selbst technischer: KI-gestützte Tools für Faktenchecks, Stilanalysen oder personalisierte News-Feeds wandern auf Smartphones. Diese partizipative Medienkompetenz verlagert Verantwortung nicht nur auf Redaktionen, sondern verteilt sie breiter in die Gesellschaft.

Die zentrale Zukunftsaufgabe lautet daher, einen Diskurs zu schaffen, in dem Entwickler:innen, Journalist:innen und Nutzer:innen KI gemeinsam reflektieren. KI-Ethik wird sich in den kommenden Jahren weniger über neue PDFs definieren als über gelebte Praxis in Redaktionen, über gesetzliche Rahmenbedingungen und über eine Gesellschaft, die zunehmend versteht, wie Medien und Technologie funktionieren.

Ludwig hat nun das Förderprogramm für Abschlussarbeiten durchlaufen. Du hast auch ein spannendes Thema? Melde dich bei uns!